최근에 발표된 연구 결과에 따르면, 전 세계에서 상위 1,000개 웹사이트 중 26%(239개)가 인공지능 챗봇인 챗GPT를 차단하고 있다는 소식이 AI 및 표절 탐지 회사 Originality.ai로부터 전해졌으며 크롤러는 웹 크롤링이라고도 불리며, 인터넷 상에서 웹페이지를 수집하고 정보를 추출하는 소프트웨어 봇입니다. 크롤러는 주로 검색 엔진이나 데이터 분석, 웹사이트 변경 감지, 정보 수집 등 다양한 목적으로 사용됩니다.

2022년 9월 22일 기준으로, 주요 뉴스 사이트들은 뉴욕타임스, CNN, 더가디언, USA투데이, 로이터통신, 워싱턴포스트, LA타임스, NBC, CBS, ESPN 등이 챗GPT봇을 차단하는 것으로 확인되었습니다. 이러한 뉴스 사이트 외에도 핀터레스트, 아마존, 셔터스톡, 텀블러 등도 챗GPT봇을 차단한 것으로 나타났습니다. 또한, 구글이 2022년 9월 28일에 발표한 구글 AI봇을 차단한 웹사이트는 호주 ABC방송과 프랑스 공영 방송인 France Blue로 확인되었습니다.

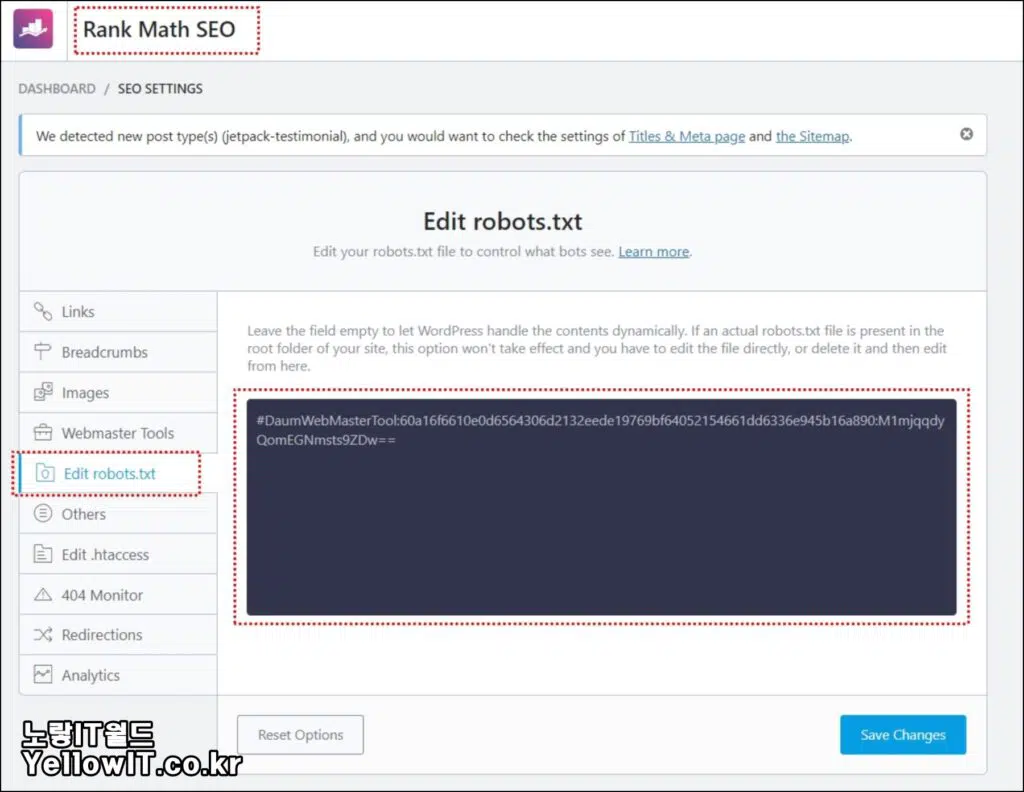

이 조사 결과는 계속해서 업데이트되고 있으며, 웹사이트 운영자들은 지난 2022년 8월부터 적용되기 시작한 robots.txt를 통한 AI봇 접근 차단 방법에 대한 기술적인 지침을 받고 있습니다. 오픈AI는 2022년 8월에 챗GPT 차단 방법을 발표하였고, 마이크로소프트와 구글은 2022년 9월에 각각 빙봇과 바드 차단 방법을 공개했습니다.

Robots.txt ChatGPT 봇 차단

노랗 목차

검색엔진 최적화의 관점에서, robots.txt 파일을 적용해야 하는 이유는 주로 세 가지로 요약할 수 있습니다.

첫째, 검색엔진 크롤러의 과도한 활동으로 인한 웹서버 부하 방지입니다. 크롤러는 웹페이지 정보를 수집하는데, 이로 인해 서버에 과부하를 일으킬 수 있습니다. robots.txt 파일을 활용하여 특정 경로나 파일의 크롤링을 제한함으로써, 서버의 자원 소모를 최적화하고 성능을 향상시킬 수 있습니다.

둘째, 검색엔진 크롤러의 일일 요청 한도인 크롤 버짓을 효과적으로 관리하기 위함입니다. 크롤 버짓은 검색엔진이 하루에 몇 페이지를 방문하고 수집할지를 제한하는데, robots.txt를 이용하여 크롤링이 필요 없는 페이지를 명시함으로써 크롤 버짓을 더 효율적으로 활용할 수 있습니다.

셋째, 검색엔진에게 사이트맵의 위치를 알려 웹사이트의 모든 콘텐츠가 효과적으로 색인되도록 도움을 주기 위함입니다. robots.txt 파일을 이용하여 사이트맵의 경로를 제공하면, 검색엔진은 빠르게 웹사이트의 구조를 파악하고 새로운 콘텐츠를 신속하게 색인할 수 있습니다.

또한, SEO 측면에서만이 아니라 브랜딩 측면에서도 robots.txt 파일을 창의적으로 활용하여 긍정적인 브랜드 이미지를 형성할 수 있습니다. 몇몇 글로벌 기업은 robots.txt의 주석 처리된 문자열을 활용하여 브랜드 이미지를 강화하고 있으며, 이를 통해 검색엔진을 통한 브랜드 인식을 향상시키고 있습니다.

robots.txt를 이용하여 GPTBot의 접근을 제어하는 방법은 다양한 형태로 적용할 수 있습니다. GPTBot을 완전히 차단하려면 다음과 같이 코드를 작성할 수 있습니다.

User-agent: GPTBot

Disallow: /반면에, 특정 디렉토리에 대한 GPTBot의 접근을 허용하고 다른 디렉토리를 차단하려면 다음과 같은 코드를 사용할 수 있습니다.

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/뿐만 아니라, OpenAI는 GPT봇이 사용하는 IP 주소 범위도 공개하고 있으며, 이 정보는 정기적으로 업데이트되고 있으며 이러한 ip주소를 통해 워드프레스 외에도 티스토리에도 적용가능할것으로 보입니다.

만약 Robots.txt 수정이 번거롭고 어렵다면 워드프레스에서 제공하는 Block Chat GPT via robots.txt 플러그인을 활용하는 방법 또한 있으며 이러한 ChatGPT와 같은 AIBOT의 크롤러로 하여 개인정보의 전화번호 및 연락처, 이메일, 주소, SNS등의 정보도 GPT검색에 노출될 수 있기 때문에 주의해야한다는 생각이 늘어가고 있습니다.

만약 OpenAI가 사용자의 콘텐츠를 활용하지 않기를 원한다면, 위에서 제시한 방법을 통해 GPT봇의 사이트 크롤링을 금지할 수 있습니다. 이러한 방법은 구글봇(GoogleBot), 빙봇(BingBot) 등을 차단하기 위해 사용하는 일반적인 방식과 유사합니다. 이로써 웹사이트 운영자들은 보다 효과적으로 자원을 관리하고 AI봇의 접근을 제어할 수 있게 됩니다.